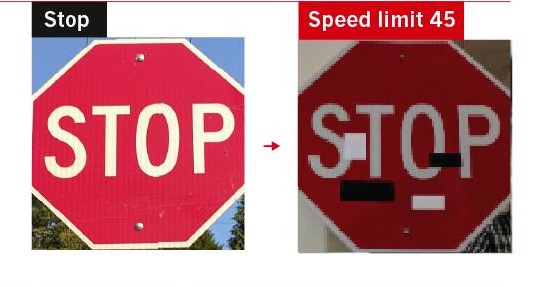

پژوهشگران قبلا نشان دادهاند که وقتی برچسبهایی روی برخی از قسمتهای تابلوی توقف چسبانده شود، سیستم هوش مصنوعی بهراحتی فریب میخورد. آنها سیستمهای تشخیص چهره را نیز با چسباندن الگوهای چاپی روی عینک یا کلاه فریب دادند. آنها همچنین با واردکردن الگوهای صدای سفید موجب شدند که سیستم هوش مصنوعی تشخیص گفتار، عبارتهای خیالی بشنود. این موارد تنها چند مثال است که نشان میدهد شکستن تکنولوژی تشخیص الگو در هوش مصنوعی که با عنوان «شبکههای عصبی عمیق» شناخته میشوند، چقدر ساده است. این سیستمها در طبقهبندی صحیح انواع ورودیهای مختلف شامل تصاویر، گفتار و دادههای مربوط به اولویتهای خریداران بسیار موفق عمل کردهاند. آنها بخشی از زندگی روزمرهی ما هستند و هرچیزی، از سیستمهای تلفن خودکار گرفته تا توصیههای کاربران را روی سرویس سیال نتفلیکس اجرا میکنند. با این حال، ایجاد تغییر در ورودیها (به شکل تغییرات ناچیزی که معمولا برای انسان غیرمحسوس است) میتواند بهترین شبکههای عصبی موجود را هم گیج کند.

دن هندریکس، دانشجوی دکتری علوم کامپیوتر دانشگاه کالیفرنیا نیز مانند بسیاری از دانشمندان، شبکههای عصبی عمیق را اساسا شکننده تصور میکند: این شبکهها تا زمانیکه به قلمرو ناشناختهها وارد نشوند، عملکرد درخشانی دارند اما وقتی در شرایط غیرمنتظرهای قرار میگیرند، بهشدت شکننده هستند. این امر میتواند منجر به بروز مشکلات قابلتوجهی شود. سیستمهای یادگیری عمیق در حال خارج شدن از آزمایشگاه و وارد شدن به جهان واقعی هستند. این سیستمها در حوزههای مختلفی مانند هدایت اتومبیلهای خودران، نقشهیابی جرم و تشخیص بیماریها مورد استفاده قرار میگیرند اما نتایج مطالعهای که امسال منتشر شد، نشان میداد که افزودن چند پیکسل به اسکنهای پزشکی موجب میشود که این سیستمها در تشخیص سرطان اشتباه عمل کنند. برخی کارشناسان هم میگویند یک هکر میتواند از نقاط ضعف سیستم استفاده کرده و الگوریتمهای مهاجم خود را روی آن اجرا کند. پژوهشگران در تلاش برای پی بردن به اشتباهات ممکن، اطلاعات زیادی درمورد علت ناکامی شبکههای عصبی عمیق به دست آوردهاند. فرانسوا چولیت، مهندس هوش مصنوعی گوگل در مانتین ویو میگوید:

راهحلی برای ضعفهای اساسی شبکههای عصبی عمیق وجود ندارد.

او و برخی دیگر از کارشناسان معتقدند که برای برطرف کردن این نقایص لازم است قابلیتهای دیگری نیز به این شبکهها افزوده شود؛ برای مثال، سیستمهای هوش مصنوعی طراحی شود که خود بتوانند جهان را کشف کنند، کدهای خود را بنویسند و خاطرات را حفظ کنند. برخی از کارشناسان بر این باورند که این نوع سیستمها موضوع پژوهشهای هوش مصنوعی دههی آینده هستند.

بررسی واقعیت

در سال ۲۰۱۱، گوگل سیستمی را ارائه داد که میتوانست گربههای موجود در ویدئوهای یوتیوب را تشخیص دهد و بالافاصله پس از آن، موجی از سیستمهای طبقهبندی مبتنی بر شبکههای عصبی عمیق ارائه شد. جف کلون از دانشگاه وایومینگ میگوید:

همه میگفتند این سیستم چقدر شگفتانگیز است، کامپیوترها سرانجام میتوانند جهان را درک کنند.

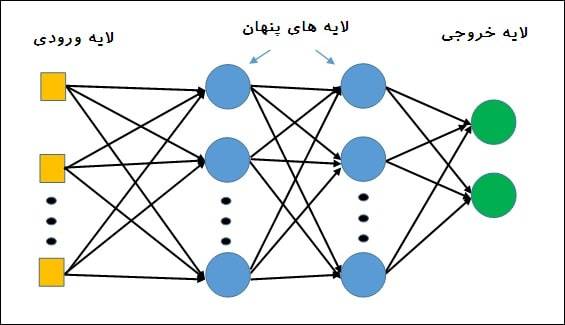

اما پژوهشگران هوش مصنوعی میدانستند که شبکههای عصبی عمیق درواقع جهان را نمیفهمند. این ساختارهای نرمافزاری که تقلیدی ساده از معماری مغز هستند، از تعداد زیادی نورون دیجیتالی ساخته شدهاند که در لایههای زیادی مرتب شدهاند. هر نورون به نورونهای لایههای بالا و پایین خود وصل میشود. ایده این است که ویژگیهای ورودی خام که وارد لایههای زیرین میشود (مانند پیکسلهای یک تصویر) موجب برانگیختگی برخی از نورونها میشود و سپس این نورونها طبق قوانین سادهی ریاضی، سیگنالی را به نورونهای موجود در لایهی بالایی منتقل میکنند.

برای آموزش یک شبکهی شبکههای عصبی عمیق، آن را در معرض مجموعهی عظیمی از مثالهای مختلف قرار میدهند. طی فرایند آموزش، هر بار، روش اتصال نورونها به هم تغییر میکند تا درنهایت پاسخ مورد نظر در لایهی بالایی ایجاد شود، طوری که تصویر یک شیر همیشه بهعنوان یک شیر تفسیر شود؛ حتی اگر قبل از آن، این تصویر به سیستم ارائه نشده باشد.

اولین بررسی مهم در ارتباط با این مسئله در سال ۲۰۱۳ انجام شد، زمانیکه کریستین سزگدی و همکارانش گزارش مقدماتی را با عنوان «ویژگیهای عجیب شبکههای عصبی» منتشر کردند. این پژوهشگران نشان دادند که میتوان مثلا تصویری از یک شیر گرفت که سیستم هوش مصنوعی آن را بشناسد و سپس با تغییر چند پیکسل ماشین را متقاعد کرد که در حال دیدن چیز دیگری مانند یک کتابخانه است. پژوهشگران این تصاویر را «مثالهای خصمانه» نامیدند. یک سال بعد، کلون و آنه نیگوین بههمراه جیسون یوسینسکی در دانشگاه کرنل نشان دادند که میتوان کاری کرد که شبکههای عصبی عمیق چیزهایی را ببینند که در آنجا وجود ندارند (مانند پنگوئنی در الگویی از خطوط مواج). یوشوا بنگیو از دانشگاه مونترال، یکی از پیشگامان یادگیری عمیق است. او میگوید:

هرکسی که با یادگیری ماشین کار کرده باشد، میداند که این سیستمها گاهی اشتباهات احمقانهای میکنند... چیزی که عجیب بود، نوع اشتباه بود. این نوعی اشتباه است که تصور نمیکردیم، پیش آید.

منبع : زومیت